我們擅長商業策略與用戶體驗的完美結合。

歡迎瀏覽我們的案例。

人類歷史上,第一個可編程憶阻器計算機誕生,不再需要將語音命令發送到云端進行解釋,直接在智能手機上通過 AI 處理器完成,極大的加快響應時間。在一些更加注重私密性的場景比如醫療設備中,具有更好的安全性和隱私性。

你有沒有想過,智能手機將來也有可能直接處理復雜的人工智能任務?關鍵在它:人類歷史上,第一個可編程憶阻器計算機。

不僅僅是通過外部計算機操作的憶阻器陣列,密歇根大學開發的這個可編程憶阻器計算機,可以直接在小型、能量受限的設備(如智能手機和傳感器)上處理人工智能任務。

也就是說,在未來,不再需要將語音命令發送到云端進行解釋,直接在智能手機上通過 AI 處理器完成,極大的加快響應時間。在一些更加注重私密性的場景比如醫療設備中,能夠實現更好的安全性和隱私性。

人工智能強大的算力帶來的負面影響之一就是巨額的能耗。每個人都希望在智能手機上安裝 AI 處理器,但你肯定不希望手機一天充電 12 次。

為什么憶阻器有利于機器學習

這里提到的憶阻器的高級計算機組件,是具有存儲器、可變電阻的電阻器,可用作信息存儲。

由于憶阻器在同一位置存儲和處理信息,因此它們可以解決掉計算速度及功耗的殺手——內存和處理器之間的連接。

這對于處理大量數據的機器學習算法尤其重要,例如識別照片和視頻中的對象,或預測哪些醫院患者具有較高的感染風險。

如今,程序員已經習慣于在圖形處理單元(GPU)而不是 CPU 上運行這些算法。

“就功率和吞吐量而言,GPU、定制的優化數字電路被認為比 CPU 好 10 到 100 倍。”Lu 說。“憶阻器 AI 處理器可能會再好上 10 到 100 倍。”

GPU 在機器學習任務中表現優秀,因為它們有數千個小核心可以同時運行計算。憶阻器陣列則更進一步,每個憶阻器都能夠獨立進行計算,一個內核里可以一次性執行數千次操作。

本次用于實驗的計算機擁有超過 5800 個憶阻器。而用于商業的話,可能包括數百萬個。

憶阻器陣列特別適合解決機器學習任務,這是因為機器學習算法將數據轉換為向量。例如,預測患者在醫院的感染風險時,該向量可以將存在感染風險的因素以數字表示列出。

然后,機器學習算法將這些“輸入”向量,與在存儲器中的“特征”向量進行比較。如果匹配,則系統知道輸入數據具有該特征。向量存儲在矩陣中,類似于數學電子表格,這些矩陣可以直接映射到憶阻器陣列上。

更重要的是,當數據通過陣列反饋時,大部分數學處理通過憶阻器中的自然電阻發生,消除了將特征向量移入和移出存儲器而導致的額外計算。這使得陣列在復雜的矩陣計算中非常高效。

早期的研究證明了憶阻器陣列有可能加速機器學習,但它們需要外部計算元件才能運行。

構建可編程憶阻器計算機

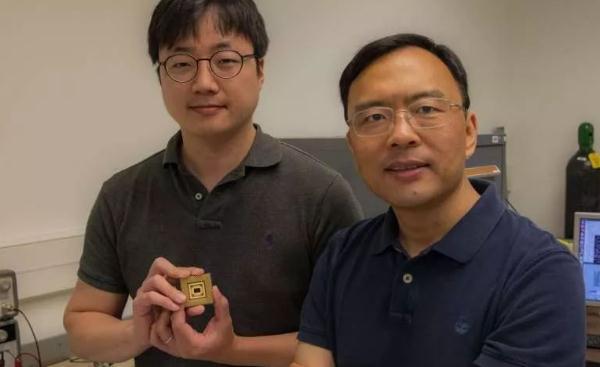

為了構建第一臺可編程憶阻器計算機,Lu 的團隊與U-M 的電子和計算機工程副教授 Zhengya Zhang 和 Michael Flynn 教授一起設計了一個芯片,可以將憶阻器陣列與編程和運行所需的所有其他元件集成在一起。

這些組件包括傳統的數字處理器和通信通道,以及數字/模擬轉換器,用作模擬憶阻器陣列和計算機其余部分之間的解釋器。

然后,Lu 的團隊將憶阻器陣列直接集成在U-M 的 Lurie Nanofabrication Facility 的芯片上。他們還開發了將機器學習算法映射到憶阻器陣列的矩陣結構上的軟件。

該團隊使用三種基本機器學習算法演示了該設備:

感知機(Perceptron),用于對信息進行分類。能夠 100% 準確地識別出不完美的希臘字母

稀疏編碼,壓縮并分類數據,特別是圖像。計算機能夠找到最有效的方法來重建一組圖像,并以 100% 的準確度識別出其模式

雙層神經網絡,旨在尋找復雜數據中的模式。這個雙層網絡在乳腺癌篩查數據中找到了共性和差異因素,然后將每個病例分類為惡性或良性,準確率為 94.6%

擴展商業用途存在挑戰。但 Lu 計劃將這項技術商業化。該研究的標題是“完全集成的可重編程憶阻器-CMOS 系統,用于高效的乘法累加運算。”

(邯鄲網站建設)